「作者完美呈現監管單位觀點、風險管理、可解釋性與其他諸多主題的概觀,同時提供實務建議與程式碼範例。」

—Christoph Molnar

Interpretable Machine Learning作者

「使用獨特戰術處理方式,解決ML系統風險,讓本書脫穎而出。透過細微差異的處理降低ML風險,為讀者提供寶貴資源,以負責任又可持續的方式成功佈署ML系統。」

—Liz Grennan

Digital Trust, McKinsey&Company初級合夥人暨全球事務共同領導者

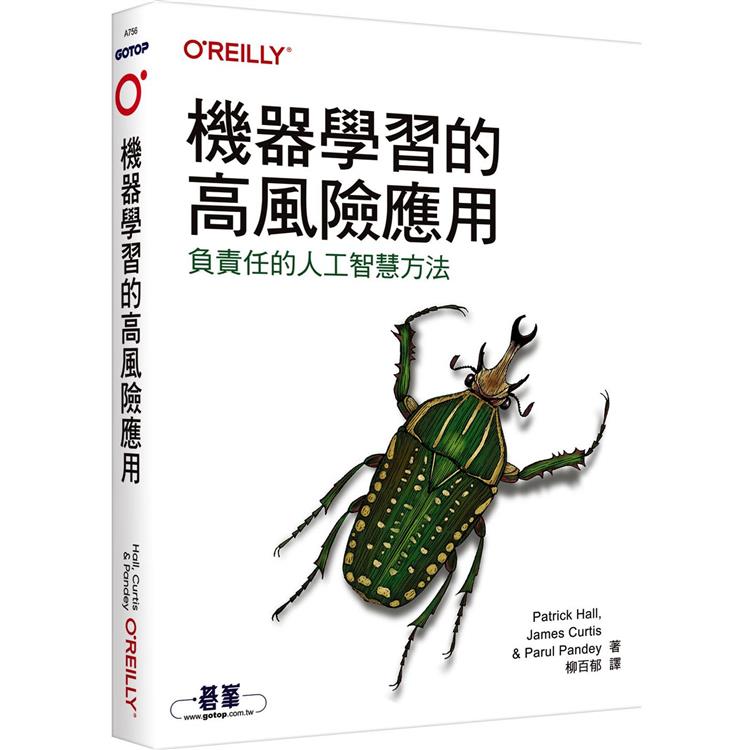

過去十年,見證了人工智慧與機器學習(AI/ML)技術的廣泛採用。然而,疏於監督這些廣泛實施的技術,導致原本可由適切風險管理來避免的事故與不良後果。在認識AI/ML真正的好處前,從業人員必須瞭解如何降低風險。

本書說明負責任AI的處理方式:建立在風險管理、資安、資料隱私上,並套用社交科學的最佳實作,提升AI/ML技術、商業程序與文化能力的完整框架。作者Patrick Hall、James Curtis與Parul Pandey創作了這本指南,以期能協助企業、客戶與大眾改善真實世界AI/ML系統結果的資料科學家。

‧學習完整涵蓋可解釋性、模組驗證與除錯、偏見管理、資料隱私與ML安全性的負責任AI技術處理

‧學習如何建立成功的、有影響力的AI風險管理實作

‧對採用AI技術的現有標準、法律與評估方式有基本瞭解,包括近期的NIST AI Risk Management Framework

‧使用GitHub與Colab的互動式資源

| FindBook |

有 3 項符合

機器學習的高風險應用|負責任的人工智慧方法的圖書 |

|

機器學習的高風險應用|負責任的人工智慧方法【金石堂、博客來熱銷】 作者:Patrick Hall、James CurtisPa 出版社:歐萊禮股份有限公司 出版日期:2024-04-02 |

| 圖書選購 |

| 型式 | 價格 | 供應商 | 所屬目錄 | $ 702 |

科技趨勢 |

$ 702 |

科學科普 |

$ 741 |

中文書 |

|---|

| 圖書館借閱 |

| 國家圖書館 | 全國圖書書目資訊網 | 國立公共資訊圖書館 | 電子書服務平台 | MetaCat 跨館整合查詢 |

| 臺北市立圖書館 | 新北市立圖書館 | 基隆市公共圖書館 | 桃園市立圖書館 | 新竹縣公共圖書館 |

| 苗栗縣立圖書館 | 臺中市立圖書館 | 彰化縣公共圖書館 | 南投縣文化局 | 雲林縣公共圖書館 |

| 嘉義縣圖書館 | 臺南市立圖書館 | 高雄市立圖書館 | 屏東縣公共圖書館 | 宜蘭縣公共圖書館 |

| 花蓮縣文化局 | 臺東縣文化處 |

|

|

圖書介紹 - 資料來源:博客來 評分:

圖書名稱:機器學習的高風險應用|負責任的人工智慧方法

內容簡介

作者介紹

作者簡介

Patrick Hall

Patrick Hall 是BNH.AI首席科學家與GWU客座講師成員。

James Curtis

James Curtis 是Solea Energy定量分析研究員。

Parul Pandey

Parul Pandey 是H2O.ai首席資料科學家。

Patrick Hall

Patrick Hall 是BNH.AI首席科學家與GWU客座講師成員。

James Curtis

James Curtis 是Solea Energy定量分析研究員。

Parul Pandey

Parul Pandey 是H2O.ai首席資料科學家。

|